Algorithmisch Rekursive Sequenzanalyse | ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

Algorithmischer Strukturalismus: Formalisierung genetischer Strukturalismus: Ein Versuch, dazu beizutragen, den genetischen Strukturalismus falsifizierbar zu machen

Natural Language Processing:

PDF Deutsch

Die Algorithmisch Rekursive Sequenzanalyse ist eine Methode zur Kausalinferenz mit Handlungsgrammatiken und Graphen. Im Gegensatz zu Poststrukturalisten, Postmodernisten, kritischen Posthumanisten, Konstruktivisten und Tiefenhermeneuten nimmt sie Karl Popper, Ulrich Oevermann, Chomsky, Pearl, Bayes, LISP, SCHEME, R und Python sehr ernst.

Algorithmic Recursive Sequence Analysis is a method for causal inference using action grammars and graphs. In contrast to poststructuralists, postmodernists, critical posthumanists, constructivists and depth hermeneutics, she takes Karl Popper, Ulrich Oevermann, Chomsky, Pearl, Bayes, LISP, SCHEME, R and Python very seriously.

Empirical social research is currently developing in three directions:

With the founding of the German Academy for Sociology, in Germany quantitative social research has regained importance and students have to learn the necessary basics again during their studies.

Qualitative social research continues on its way between deep hermeneutics and Oevermannian sequence analysis.

Multi-agent systems, neural nets, cellular automata, etc. continue to form the basis for the development of artificial social systems.

What is missing is qualitative social research that provides the empirically proven protocol languages for such artificial social systems, which serves to simulate empirically proven models (https://github.com/pkoopongithub). This is not possible with large language models, which hardly go beyond the explanatory value of Markov chains, but only with graph-based models that depict causal inference and rule-based action in an explanatory manner.

Die empirische Sozialforschung entwickelt sich derzeit in drei Richtungen:

Mit der Gründung der Deutschen Akademie für Soziologie hat in Deutschland die quantitative Sozialforschung wieder an Bedeutung gewonnen und die Studierenden müssen sich während des Studiums die notwendigen Grundlagen neu aneignen.

Die qualitative Sozialforschung bewegt sich weiter zwischen Tiefenhermeneutik und Oevermannscher Sequenzanalyse.

Multiagentensysteme, neuronale Netze, zellulare Automaten etc. bilden weiterhin die Grundlage für die Entwicklung k¨nstlicher sozialer Systeme.

Was fehlt, ist eine qualitative Sozialforschung, die die empirisch erprobten Protokollsprachen für solche künstlichen Sozialsysteme bereitstellt, die dazu dient, empirisch erprobte Modelle zu simulieren (https://github.com/pkoopongithub). Das geht nicht mit Large Language Modellen, die kaum über den Erklärungswert von Markow-Ketten hinausgehen, sondern nur mit graphenbasierten Modellen, die kausale Inferenz und regelbasiertes Handeln erklärend abbilden.

Wenn man einen Hammer bauen will und eine Rakete fertigt, hat man auf hohem Niveau schlechte Arbeit gemacht. Und wenn man ein Lehrbuch der Volkswirtschaft schreiben will und einen Softwareagenten erschafft, der gerne mit Aktien handelt, hat man auf hohem Niveau schlechte Arbeit gemacht. Schlechte Arbeit hätte man auch gemacht, wenn man einen Chatbot erhält, weil man die Soziologie der latenten generativen Strukturen von Verhandlungen zwischen Käufer und Verkäufer algorithmisch beschreiben will. Solche Modelle benötigen weder postmoderne Tiefenhermeneutik oder postmoderne Dekonstruktion noch Large Language Modelle von Chatbots, sondern die syntaktische Analyse der regelbasierten Strukturen solcher sozialer Systeme.

If you want to build a hammer and a rocket manufactures you have done a bad job at a high level. And if you want to write an economics textbook and create a software agent that likes to trade stocks, you've done a bad job at a high level. You would have done bad work if you had a Chatbot obtained because one wants to algorithmically describe the sociology of the latent generative structures of negotiations between buyers and sellers. Such models require neither postmodern deep hermeneutics nor postmodern deconstruction, nor large language model chatbots, but the syntactic analysis of the rule-based structures of suchmore social systems.

Posthumanismus und Transhumanismus müssen die Opake KI entweder parasitieren oder ihre Symbionten sein. Denn sie leben entweder von ihrer Opazität oder die Liebe zur Opazität ist ihre gemeinsame Wurzel. In dem Fall aber haben sie alle Drei Karl Popper durch Harry Potter ersetzt und betreiben Magie. Denn bei ausreichender Speicherkapazität und genügend Rechengeschwindigkeit wirkt jeder reine Markov-Generator intelligent und Markov-Generatoren, die mit hoher Rechengeschwindigkeit über einer ausreichend groÃen Speicherkapazität arbeiten, sind der Cargo-Kult des Verstandes.

Posthumanism and transhumanism must either parasitize the Opaque AI or be its symbiote. Because they live either from their opacity or the love for opacity is their common root. In this case, however, they have all three replaced Karl Popper with Harry Potter and practice magic. Because with sufficient storage capacity and sufficient computing speed, everyone looks pureMarkov Generator intelligent and Markov generators with high computing speed over a sufficient huge storage capacity work are the cargo cult of the mind.

Generative Pre-Trained Transformers (GPT) und Large Language Models (LLM) gehen kaum über den Erklärungswert von Markow-Ketten hinaus und müssen zudem mit der Wissensbasis empirisch ermittelter Dialoggrammatiken (Algorithmisch rekursive Sequenzanalyse) und agentenorientierter gewichteter Entscheidungstabellen für eine bessere Ergebnisqualität optimiert werden. Nur so werden Diaogschnittstellen glaubwürdiger als Markow-Generatoren und nur so werden Protokollsprachen für Agenten empirisch bewährte Dialogstrukturen abbilden. Generative Pre-Trained Transformers (GPT) and Large Language Models (LLM) hardly go beyond the explanatory value of Markov chains and must also be optimized with the knowledge base of empirically determined dialog grammars (algorithmically recursive sequence analysis) and agent-oriented weighted decision tables for better quality results. Only in this way will dialog interfaces become more credible than Markov generators and only in this way will protocol languages for agents map empirically proven dialog structures. Les transformateurs génératifs pré-entraînés (GPT) et les grands modèles de langage (LLM) ne dépassent guère la valeur explicative des chaînes de Markov et doivent également être optimisés avec la base de connaissances des grammaires de dialogue déterminées empiriquement (analyse de séquence récursive algorithmique) et la décision pondérée orientée agent. tableaux pour des résultats de meilleure qualité. Ce n'est qu'ainsi que les interfaces de dialogue deviendront plus crédibles que les générateurs de Markov et ce n'est qu'ainsi que les langages de protocole pour les agents cartographieront des structures de dialogue éprouvées empiriquement. Los Transformadores Generativos (GPT) y los Modelos de Lenguaje Largo (LLM) pre-entrenados difÃcilmente van más allá del valor explicativo de las cadenas de Markov y también deben optimizarse con la base de conocimientos de las gramáticas de diálogo determinadas empÃricamente (análisis de secuencias recursivas algorÃtmicas) y decisiones ponderadas orientadas a agentes . tablas para obtener mejores resultados. Solo entonces las interfaces de diálogo se vuelven más creÃbles que los generadores de Markov y solo entonces los lenguajes de protocolo para los agentes mapean estructuras de diálogo probadas empÃricamente.

Abstract: Die Algorithmisch Rekursive Sequenzanalyse (Aachen 1994) ist eine Methode zur

Analyse endlicher diskreter Zeichenketten. Ndiaye, Alassane (Rollenübernahme als Benutzermodellierungsmethode : globale Antizipation in einem transmutierbaren Dialogsystem 1998) und KrauÃe, C. C., & Krueger,F.R. (Unbekannte Signale 2002) veröffentlichten äquivalente Methoden. Genial ist, etwas Einfaches einfach zu denken.

Seit Anfang des 21. Jahrhunderts wird die Konstruktion von Grammatiken aus gegebenen empirischen Zeichenketten in der Computerlinguistik unter dem Stichwort Grammatikinduktion diskutiert (Alpaydin, E. (2008): Maschinelles Lernen, Shen, Chunze(2013): Effiziente Grammatikinduktion ) oder (Dehmer 2005 Strukturelle Analyse)(Krempel 2016 Netze, Karten, Irrgärten). Mit sequitur definieren Nevill-Manning Witten (Identifying Hierarchical Structure in Sequences: A linear-time algorithm 1999) eine Grammar Induktion zur Komprimierung von Zeichenketten. Graphen, Grammatiken und Transformationsregeln sind natürlich erst der Anfang. Denn eine Sequenzanalyse ist erst abgeschlossen, wenn, wie bei der algorithmisch rekursiven Sequenzanalyse mindestens eine Grammatik angegeben werden kann für die ein Parser die Sequenz als wohlgeformt identifiziert, mit der ein Transduktor künstliche Protokolle erzeugen kann, die äquivalent zur untersuchten empirschen Sequenz sind und zu der ein Induktor mindestens eine äquivalente Grammatik erzeugen kann. Gold (1967) formulierte das Problem in Antwort auf Chomsky (1965). Der algorithmische Strukturalismus ist widerspruchsfrei, empirisch bewährt, galileisch, naturalistisch, darwinisch und ein Ärgernis für tiefenhermeneutische, konstruktivistische, postmodernistische und (post)strukturalistische Sozialphilosophen. Ich freue mich über Erben, die die Arbeit fortsetzen oder sich inspirieren lassen.

Eine soziale Handlung ist ein Ereignis im

Möglichkeitsraum aller sozialen Handlungen. Der Sinn einer sozialen Handlung ist

die Menge aller möglichen Anschlusshandlungen und ihrer

Auftrittswahrscheinlichkeit. Der Sinn muss nicht deutend verstanden werden

sondern kann empirisch rekonstruiert werden. Die Rekonstruktion kann durch

Bewährungsversuche an empirischen Protokollen bewährt- oder falsifiziert werden. Seit Mitte der 1970er bis heute finden irrationalistische oder antirationalistische Ideen unter akademischen Soziologen in Amerika, Frankreich, GroÃbritannien und Deutschland zunehmend Verbreitung. Die Ideen werden als Dekonstruktionismus, Tiefenhermeneutik, Wissenssoziologie, Sozialkonstruktivismus, Konstruktivismus oder Wissenschafts- und Technologieforschung bezeichnet. Der Überbegriff für diese Bewegungen ist (Post)strukturalismus oder Postmodernismus. Alle Formen des Postmodernismus sind antiwissenschaftlich, antiphilosophisch, antistrukturalistisch, antinaturalistisch, antigalileisch, antidarwinisch und allgemein antirational. Die Sicht der Wissenschaft als eine Suche nach Wahrheiten (oder annähernden Wahrheiten) über die Welt wird abgelehnt. Die natürliche Welt spielt eine kleine oder gar keine Rolle bei der Konstruktion wissenschaftlichen Wissens. Die Wissenschaft ist nur eine andere soziale Praxis, die Erzählungen und Mythen hervorbringt, die nicht mehr Gültigkeit haben als die Mythen vorwissenschaftlicher Epochen. Thematisch bewegt sich der Algorithmische Strukturalismus im Grenzgebiet zwischen Informatik und Soziologie. Die Algorithmische Strukturalismus unterstellt, dass die soziale Wirklichkeit selbst (Wetware, Welt 2) nicht kalkülfähig ist. Die soziale Wirklichkeit hinterlässt bei ihrer Reproduktion und Transformation rein physikalisch semantisch unspezifische Spuren (Protokolle, Hardware, Welt 1). Diese Spuren können als Texte (diskrete endliche Zeichenketten, Software, Welt 3) verstanden werden. Es wird dann gezeigt, dass eine Approximation der Transformationregeln der sozialen Wirklichkeit (latente Sinnstrukturen, Regeln im Sinne von Algorithmen) durch Konstruktion formaler Sprachen (Welt 3, Software) möglich ist. Diese Methode ist die Algorithmisch Rekursive Sequenzanalyse. Diese linguistische Struktur ist der Motor der memetischen Reproduktion kultureller Replikatoren. Diese algorithmisch rekursive Struktur ist natürlich nicht (sic!) an Habermas und Luhmann anschluÃfähig. Galilei ist ja auch nicht an Aristoteles anschluÃfähig! Durch Lesartenproduktion und Lesartenfalsifikation wird Sequenzstelle für Sequenzstelle informell das Regelsystem erzeugt. Das informelle Regelsystem wird in ein K-System übersetzt. Mit dem K-System wird dann eine Simulation duchgeführt. Das Ergebnis der Simulation, eine terminale endliche Zeichenkette wird mit der empirisch gesicherten Spur statistisch verglichen. Das bedeutet nicht, dass Subjekte in irgendeinem Sinne von Bedeutung Regeln im Sinne von Algorithmen folgen. Die soziale Wirklichkeit ist unmittelbar nur sich selbst zugänglich. Völlig unzugänglich sind die inneren Zustände der Subjekte. Aussagen über diese inneren Zustände von Subjekten sind Derivate aus den gefundenen latenten Sinnstrukturen, Regeln im Sinne von Algorithmen. Bevor eine Annahme über den inneren Zustand eines Subjektes formuliert werden kann, müssen zuerst diese latenten Sinnstrukturen, Regeln im Sinne von Algorithmen, als Möglichkeitsraum von Sinn und Bedeutung gültig bestimmt werden. Sinn meint nicht ein ethisch gutes, ästhetisch schönes oder empathisch nachvollzogenes Leben sondern einen intelligiblen Zusammenhang, Regeln im Sinne von Algorithmen. Die latenten Sinnstrukturen, Regeln im Sinne von Algorithmen, erzeugen diachronisch eine Kette von Selektionsknoten (Parameter I), wobei sie synchronisch zum Zeitpunkt t aus dem Selektionsknoten t den Selektionsknoten t+1 erzeugen (Parameter II). Dem entspricht eine kontextfreie formale Sprache (K-Systeme), die aus dem Selektionsknoten zum Zeitpunkt t durch Anwendung von Produktionsregeln den Selektionsknoten t+1 erzeugt. Dabei ist jeder Selektionsknoten ein Zeiger auf rekursiv ineinander verschachtelte K-Systeme. So kann wie mit einem Mikroskop in die Fallstruktur hineingezoomt werden. Die Menge der K-Systeme bilden eine Case Structure Modelling Language "CSML". Die Approximation laesst sich

beliebig nahe an die Transformation der sozialen Wirklichkeit annähern. Dabei

werden den Produktionen Maße zugeordnet, die ihrer empirischen gesicherten

Pragmatik/Semantik entsprechen. Sie bilden topologisch ein rekursives Transitionsnetz

diskreter nichtmetrischer Ereignismengen ueber denen ein algorithmisches Regelsystem

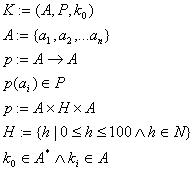

arbeitet. K- Systeme K sind formal durch ein Alphabet (

Das Auftrittsmaà h läÃt sich spieltheoretisch expandieren (vgl. Diekmann). Vom Axiom k0 ausgehend, erzeugt ein K-System eine Zeichenkette k0k1k2... indem die Produktionsregel p auf das Zeichen i einer Kette angewendet wird: Ein strenges Maà für die Zuverlässigkeit der Zuordnung der Interakte zu den Kategorien (vorläufige Formative da im Prinzip ad infinitum zu approximieren) ist die Anzahl der von allen Interpreten übereinstimmend vorgenommene Zuordnung (vgl MAYRINGl99O,S.94ff, LISCH/KR1Z1978,S.84ff). Diese Zahl muà dann noch durch Relativierung um die Anzahl der Interpreten normalisiert werden. Dieser Koeffizient ist dann definiert mit:

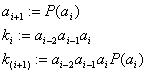

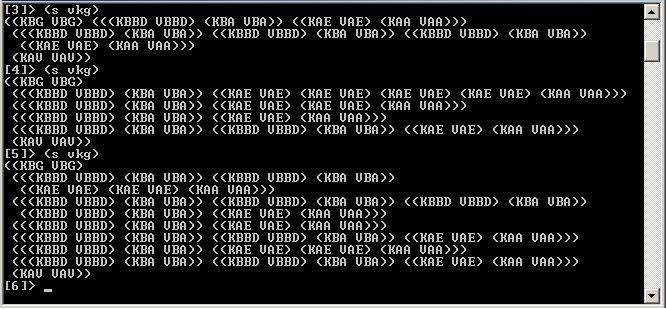

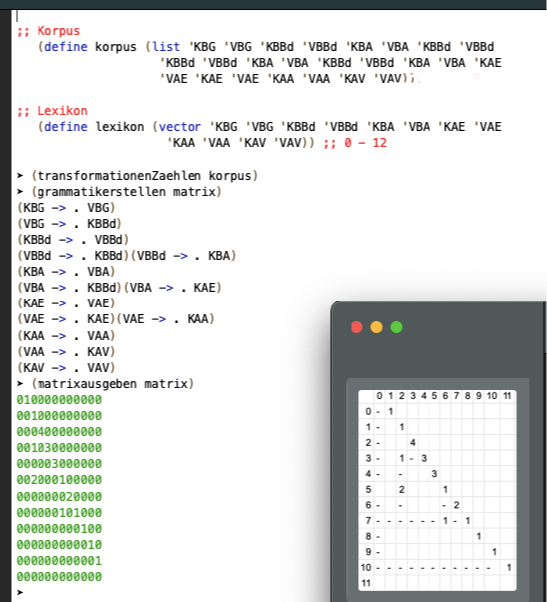

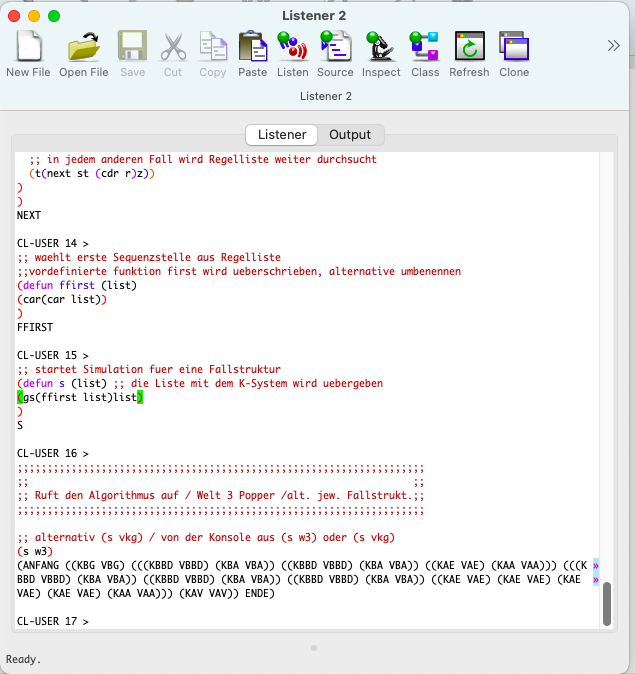

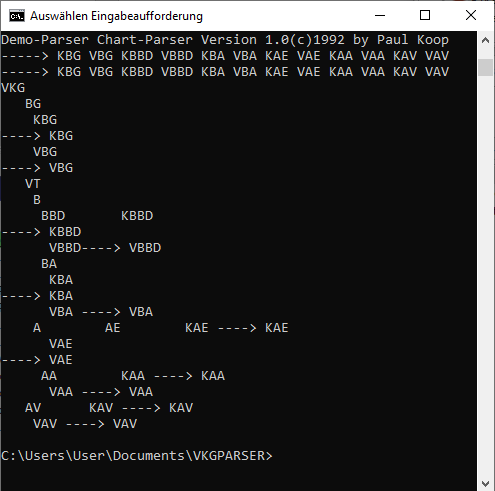

N:= Anzahl der Interpreten Z:= Anzahl der total übereinstimmenden Zuordnungen Ii:=Anzahl der Zuordnungen des Interpreten Ii Eine Beispielsitzung unter clisp mit dem K-system für Verkaufsgespräche: Das Beispiel ist Ergebnis umfangreicher Sequenzanalysen von Verkausgesprächen in den Jahren 1994, 1995 und1996. Dabei wurden in großem Umfang Spuren von Verkaufs- und Kaufsinterakten gesichert: Tonbandprotokolle von Interakten im Einzelhandel und auf Märkten. Eine Auswahl dieser Protokolle wurden transkribiert und einer umfangreichen objektiv hermeneutischen Interpretation unterworfen. Aus dieser Auswahl wurde dann ein Transkript einer aufwendigen vollständigen Algorithmisch Rekursiven Sequenzanalyse unterworfen. Alle Arbeiten wurden umfangreich dokumentiert und vollständig zusammengefasst. (Die Dokumente werden auf Anfrage gerne vollständig zur Verfügung gestellt.)

Paul Koop K-System VKG Transduktor Verkaufsgespräch in Lisp

Paul Koop K-System VKG Induktor Sitzung Scheme

Paul Koop K-System VKG Transduktor Sitzung mit Lisp

Paul Koop K-System VKG PARSER Sitzung an der Konsole (Erstellt mit Object Pascal) Die Zeichen der Zeichenkette sind ohne vordefinierte Bedeutung. Theoretisch relevant ist allein die Syntax ihrer Verknüpfung. Sie definiert die Fallstruktur. Die semantische Interpretation der Zeichen ist alleine eine Interpretationsleistung eines menschlichen Lesers. Im Prinzip ist auch eine visuelle Interpretation (die animiert werden kann) etwa zur automatischen Synthese von Filmsequenzen möglich.: Ein menschlicher Leser kann die Zeichen interpetieren:

https://github.com/pkoopongithub Es wurde ein Reliabilitätskoeffizient von gemessen. Die soziale Wirklichkeit selbst aber ist nicht kalkülfähig und nur sich selbst im Moment der Transformation zugänglich. Geisteswissenschaftliche, konstruktivistische und postmoderne Ansätze sind mir methodisch fremd. Mead, Parsons, Weber, Simmel, Mannheim/Scheler, Berger/Luckmann, Maturana, Varela, Habermas und Luhmann habe ich hinter mir gelassen. Albert, Axelrod, Esser, Diekmann, Troitzsch, Popper, Brezinka, Rössner, Dawkins, Dennett, Hofstadter, Rucker, Blackmore überzeugen mich mehr. Persönlich bevorzuge ich eine linguistische evolutionäre Perspektive und die damit verbundene Modellierung kultuteller Replikatoren mit formalen Sprachen. Aus der diskreten Struktur der Materie geht die linguistische Struktur der biologischen Evolution und die linguistische Struktur der kulturellen Replikatoren hervor. Ich bevorzuge deshalb einen algorithmischen Strukturalismus. Über die Entscheidbarkeit der GTG, 1994 Rekursive Strukturen und Prozesse, 1995 K-Systeme: Das Projekt ARS, 1994 Methodologie, 1996Algorithmisch Rekursive Sequenzanalyse, 1996 ARS Fallstruktur, 1996 Oevermann, Chomsky, Searle, 1994 | ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||